Cahier thématique n°23 - IA en santé, entre promesses et prudence

01. IA en santé : définition, contexte et enjeux

Règlement européen sur l’IA : première réglementation au monde des usages d’IA

25/07/2024

De nombreux travaux ont été menés ces dernières années afin de réguler l’usage de l’IA : recommandations de l’Organisation de coopération et de développement économiques (OCDE) en 2019, de l’OMS en octobre 2023 sur les aspects réglementaires pour le secteur de la santé ou encore le code de conduite sur l’IA (processus d’Hiroshima) du G7, également en octobre 2023.

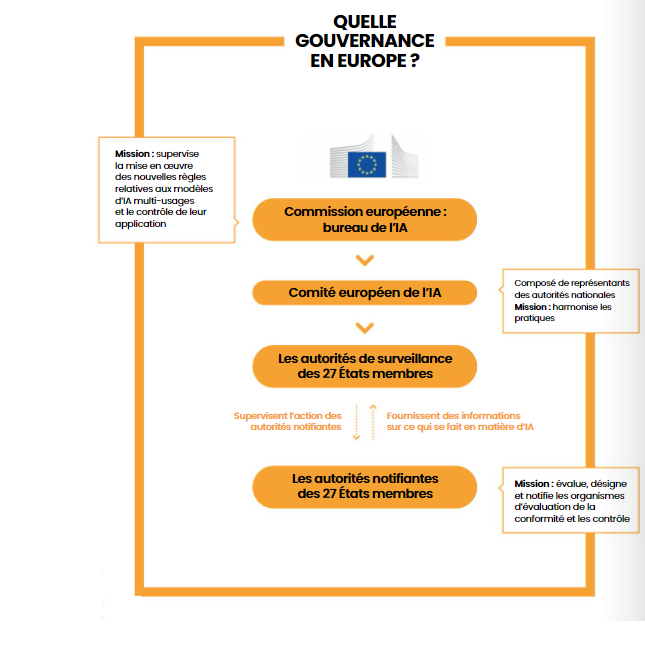

Aujourd’hui, et alors que le règlement sur l’EEDS régule l’exploitation des données (voir ci-contre), le projet de règlement européen sur l’IA s’attache à structurer et coordonner les usages des systèmes d’IA pour en maximiser les avantages. Il entrera en vigueur de façon progressive de juin 2024 à juin 2027. Notons que le cadre juridique européen qui émerge fait en bonne partie suite aux travaux menés dans le cadre de la révision de la loi de bioéthique française, à laquelle l’Ordre avait pris toute sa part. Ce règlement apparaît comme novateur puisqu’il propose de réguler les usages et les risques qui découlent de l’utilisation de l’IA plutôt que sa technologie ; il définit des règles harmonisées pour le développement, la mise sur le marché et l’utilisation des systèmes d’IA avec pour objectifs de :

- veiller à la sécurité des systèmes d’IA mis sur le marché de l’Union et à leur respect des droits fondamentaux ;

- garantir la sécurité juridique pour faciliter les investissements et l’innovation dans le domaine de l’IA ;

- renforcer la gouvernance et l’application effective de la législation existante en matière de droits fondamentaux et d’exigences de sécurité applicables aux systèmes d’IA ;

- faciliter le développement d’un marché unique pour des applications d’IA légales, sûres et dignes de confiance.

Définir les contours de l’utilisation de l’IA

Le 21 mai 2024, le texte final du règlement européen sur l’intelligence artificielle (IA Act) a été adopté par le Conseil de l’Union européenne (UE). Il aura la même force opposable que le RGPD, avec un régime de sanction financière allant de 2 à 7 % du chiffre d’affaires mondial en cas d’infraction.

Le niveau de réglementation à respecter pour un système d’IA dépendra du domaine d’application des solutions : usage général à risque limité, risque élevé, risque inacceptable…

- Certaines utilisations de l’IA seront interdites, comme des solutions introduisant une « notation sociale(8) », ou encore une manipulation du comportement humain pour contourner le libre arbitre… « Certaines exigences du règlement européen sur l’intelligence artificielle rejoignent celles du RGPD, d’autres pourront rendre difficile en pratique l’application des principes liés à la protection des données personnelles, comme le principe de minimisation des données, précise Jeanne BossiMalafosse, avocate spécialiste des données personnelles. À cet égard, la Commission européenne prévoit de publier régulièrement des “guidelines” qui nous aideront notamment à classifier les systèmes d’IA. »

- Pour les applications en santé classées parmi les systèmes à risque élevé(9), le concepteur est ainsi tenu de mener des actions obligatoires sur la collecte et la protection des données, leur qualité, la traçabilité (enregistrement dans la base de données créée par le règlement), l’information du patient sur l’usage de l’IA dans son parcours, le contrôle humain, ou encore d’établir la documentation technique nécessaire du système d’IA, d’apposer le marquage de conformité CE requis. S’y ajoutent des impératifs de cybersécurité, de prise en compte d’incidents graves et des règles de transparence dans la gestion des systèmes. « Cette transparence n’empêchera pas un certain effet “boîte noire” des systèmes d’IA les plus évolutifs, mais ceux-ci devront alors avoir une garantie humaine plus soutenue que les autres », note David Gruson, fondateur de Ethik-IA (voir p. 14). C’est pour cela que le HDH a créé une bibliothèque ouverte d’algorithmes en santé (BOAS). Les applications concernées sont par exemple : l’identification biométrique, la priorisation des appels et interventions d’urgence sanitaire et l’évaluation de l’éligibilité des personnes physiques aux prestations et services d’aide sociale et de santé.

- Quant aux systèmes d’IA générative à risque limité(10), ils devront se conformer à une exigence accrue de transparence : indiquer que le contenu a été généré par l’IA, concevoir le modèle pour l’empêcher de générer du contenu illégal, publier le résumé du corpus de données utilisées pour la formation de l’algorithme (notamment pour protéger les droits d’auteur).

Une garantie humaine dans l’IA en santé

La garantie humaine (GH) sera un principe important pour améliorer les systèmes d’intelligence artificielle (IA) en santé. Les actions correctives peuvent porter sur le dispositif algorithmique lui-même, mais aussi sur les pratiques d’utilisation ou sur le contexte organisationnel d’utilisation de cette IA, avec un dialogue collégial impliquant les professionnels de santé, les représentants de patients et les concepteurs de solutions. « Dans nos formations, on voit que la biologie et la pharmacie ont déjà, dans leur pratique professionnelle de pharmacovigilance et de matériovigilance, des réflexes qui rendent facilement adaptables ces notions de qualité, de gestion de risque, de conformité, de garantie humaine de l’IA en pharmacie », indique David Gruson, fondateur d’Ethik-IA. Le niveau de contrôle dépendra du fonctionnement d’un système d’IA, du bénéfice-risque qu’il embarque pour les patients et de la complexité du modèle algorithmique. Il faut adapter les écosystèmes de garantie humaine à la diversité des situations et des solutions. Aux professionnels de santé de prendre ce sujet à bras-le-corps, au risque que ce soient les start-ups qui décident, ou qu’elles se voient imposer des mécanismes de régulation possiblement conçus hors d’Europe.

Les professionnels de santé parties prenantes

Le premier cas d’application de garantie humaine à un système d’IA a été mis en place sous l’égide de l’Union française pour la santé bucco-dentaire pour la solution Dental Monitoring (détection avec un smartphone du risque carieux, inflammatoire ou de déchaussement dentaire déclenchant, ou non, l’intervention d’un chirurgien-dentiste). Dans ce cas précis, un collège de « réviseurs » chirurgiens-dentistes indépendants, de professionnels des établissements concernés et de représentants de patients revoit tous les trois mois une trentaine de dossiers aléatoires ou sur détection d’événements indésirables pour vérifier cette solution d’IA.

« De nombreuses publications interviennent aujourd’hui pour commenter déjà le règlement sur l’IA. Si dans certains cas, c’est utile, il convient de rester prudent et d’attendre les premières applications concrètes du texte. À cet égard, les recommandations de la CNIL, publiées le 8 avril dernier après un temps de concertation publique, constituent déjà une aide précieuse, car elles associent l’application du règlement sur l’IA et le RGPD. Mais on voit bien que même l’autorité de protection a besoin de recul et de temps pour apprécier les conséquences de l’entrée en application du texte, à l’égal de ses homologues européennes, précise Jeanne Bossi-Malafosse, en conclusion. Le cadre européen de l’IA prévoit une application progressive et les autorités européennes, comme nationales, ne laisseront pas les acteurs seuls. »

Quelle responsabilité du pharmacien en tant qu’utilisateur d’un système d’IA ?

« L’opérateur d’un système d’IA à risque élevé est objectivement responsable de tout préjudice ou de tout dommage causé par une activité, un dispositif ou un procédé physique ou virtuel piloté par un système d’IA », stipule la résolution 2020/2014 du Parlement européen. Mais qui est cet « opérateur » ?

« Il faut distinguer la responsabilité civile juridique de la question de la conformité, note David Gruson. En cas de dommage causé par l’usage normal du système d’IA dans la prise en charge ou la gestion du risque médicamenteux, par exemple, le cadrage classique de responsabilité civile s’applique : ”Est responsable celui qui a la maîtrise du processus de soins, c’est-à-dire le professionnel de santé, le médecin ou le pharmacien (ou son assureur pour les professionnels de ville), ou bien le directeur de l’hôpital (ou son assureur) en établissement ». À ce régime se substitue la responsabilité du concepteur en cas de dysfonction du système d’IA, dans le cadre du régime de responsabilité du fait des produits défectueux. « Ce cadre classique s’applique assez bien à la plupart des cas de recours à l’IA, mais moins bien aux systèmes d’IA auto-apprenants et à l’IA générative », complète David Gruson. Car le concepteur du dispositif médical ou d’un système d’IA peut échapper à sa responsabilité en cas de dysfonction de la machine, si ce risque ne pouvait pas être anticipé au regard des connaissances scientifiques disponibles au moment de la mise sur le marché (risque de développement). C’est pourquoi l’Europe a lancé un chantier sur des règles de responsabilité qui s’appliqueront à ces systèmes, par une nouvelle clé : « Soit le concepteur pourra attester d’un système de garantie humaine effectif, traçable et proportionnel, auquel cas la charge de la faute reposera sur le soignant, soit il ne pourra pas le faire et une présomption de responsabilité pèsera sur lui », conclut-il.

(8) Système de classement basé sur le comportement social ou les caractéristiques personnelles des individus.

(9) Les applications considérées comme à haut risque sont celles qui ont le potentiel de causer des dommages importants à la santé, à la sécurité ou aux droits fondamentaux des individus, et qui répondent à certains critères spécifiques définis par le règlement.

(10) Risques liés à un manque de transparence dans l’utilisation de l’IA.

Une norme Afnor volontaire pour certifier la garantie humaine

La norme certifiable de portée internationale ISO/IEC 42001 dévoilée à l’automne 2023 est le premier système normatif de management de l’IA. Son référentiel fixe le principe du contrôle de l’humain sur la machine, avec des règles relatives à la protection des données, la spécification des informations utilisées pour entraîner et alimenter l’IA, sa transparence, son explicabilité… L’objectif mis en avant par l’Afnor : favoriser une IA éthique et responsable, pour garantir la confiance en posant un cadre, sans brider l’innovation. Cette certification est proche de celle de la certification qualité pour les dispositifs médicaux. Comme tout référentiel certifiable basé sur une norme NF, le certificat sera valable trois ans avec audits de suivi et de renouvellement à la clé, précise l’Afnor.

"La garantie humaine comme principe juridique"

David Gruson,

conseiller maître à la Cour des comptes, membre du Comité consultatif national d’éthique, fondateur du think tank Ethik-IA

« L’IA en santé, nous y sommes ! Le CCNE, dans ses avis 129, puis 141, a énoncé que le premier risque éthique serait de la bloquer. Il faut donc à la fois s’ouvrir à cette vague d’innovations dans l’intérêt des patients, mais avec un certain nombre de règles. C’est pourquoi nous avons porté une méthode de garantie humaine (GH), l’idée étant de développer des écosystèmes de GH ad hoc adaptés aux usages. Cette recommandation de GH est devenue un principe juridique à travers l’article 17 de la loi bioéthique d’août 2021 et le règlement européen sur l’intelligence artificielle, pour les concepteurs (art. 14) comme les utilisateurs (art. 29). Parallèlement, Ethik-IA a travaillé avec le Digital Medical Hub de l’AP-HP sur une labellisation qui a donné le socle d’une norme Afnor. Il faut donc se préparer à ce nouveau cadre. En pharmacie, on a vu les premiers cas d’engagement avec deux solutions d’aide à la gestion du risque médicamenteux.

De telles démarches impliquent les concepteurs et les utilisateurs ; cela s’applique donc aussi aux pharmaciens, en établissements comme en ville, avec une traçabilité obligatoire pour être conforme au règlement européen sur l’IA. En tant qu’utilisateurs simples, ils pourront se contenter de demander au concepteur d’apporter la preuve de GH ; en situation de coconception ou d’adaptation de systèmes, ils devront eux-mêmes être impliqués dans une supervision de l’IA.

La GH est aussi un outil permettant d’une certaine manière de démystifier les systèmes d’IA en santé, mais aussi de les améliorer en vie réelle. Il va falloir maintenant structurer les choses, y compris avec les représentants de la pharmacie, domaine qui doit être un des fers de lance des nouveaux usages de l’IA dans les territoires de santé. »

« Pas de consentement dans les usages »

Jeanne Bossi-Malafosse,

avocate spécialiste des données personnelles*

« Dans le cadre de l’administration des soins, si le patient doit consentir aux soins qui lui sont prodigués,

aucun consentement n’est exigé au titre des règles de protection des données. Il est toutefois en principe informé au préalable de l’usage particulier qui sera fait de ses données. Par exemple, si le professionnel de santé dans le cadre du soin utilise un système fondé sur l’IA pour confirmer son diagnostic, il devra en informer son patient pour que celui-ci puisse, le cas échéant, s’y opposer (article L. 4001-3 du code de la santé publique, issu de l’article 17 de la loi bioéthique).

S’agissant de l’Espace européen des données de santé, on retrouve beaucoup des concepts développés en France depuis quelques années autour des notions d’échange et de partage de données de santé : collecte des données dans le cadre de l’usage primaire (soin), puis réutilisation à des fins de recherche, étude ou évaluation. Une des grandes discussions aura porté, dans le cas de l’Espace européen de santé, sur la nécessité ou non d’un consentement pour cette utilisation secondaire, ou bien d’un seul respect du droit d’opposition. »

* Jeanne Bossi-Malafosse a également été secrétaire générale de l’Agence du numérique en santé.